Begejstringen over de generative AI-teknologier, som ChatGPT, BARD og de store sprogmodeller, der ligger bag dem og billedgenererende modeller som Midjourney, Dall-E og Stable Diffusion er til at overse blandt kunstnere. Det er tidligere kommet frem, hvordan de data, som modellerne trænes på – også kaldet datasæt eller træningssæt – indeholder store mængder materialer, der er underlagt reglerne om ophavsret.

En artikel i magasinet The Atlantic beskrev tidligere på året, hvordan en af deres journalister fik fat på træningsdatasættet Books3, der indeholder 170.000 bøger fra de sidste 20 år. Alt sammen materiale underlagt ophavsretten. Det fik i juli måned 2023 komikeren Sara Silverman og flere andre kolleger til at lægge sag an mod OpenAI og META ift. deres modeller ChatGPT og LLaMA.

Avisen The Times tog i august 2023 konsekvensen og ændrede deres betingelser, så de ikke længere tillod techgiganterne eller andre at ”scrape” deres data fra internettet. New York Times fulgte efter og også danske medier som TV2 har lavet lignende ændringer i deres betingelser.

Afsløringerne, luk for brug af mediernes data og retssagerne har sat spørgsmålstegn ved om man overhovedet kan træne store sprogmodeller og billedgenerende modeller uden den type materialer og startet debatten om forskellige modeller for hvordan man kunne forsætte med at træne modellerne på de nødvendige data.

Forskere spreder gift

Der er store økonomiske interesser på spil fra begge sider i konflikten. Nu har kunstnerne fået et nyt våben i kampen mod techgiganterne. Professor ved University of Chicago, Ben Zhao, og hans samarbejdspartnere har udviklet et nyt værktøj, som de kalder Nightshade – natskygge. Ligesom sin navnefælle, så er Nightshade-værktøjet giftigt.

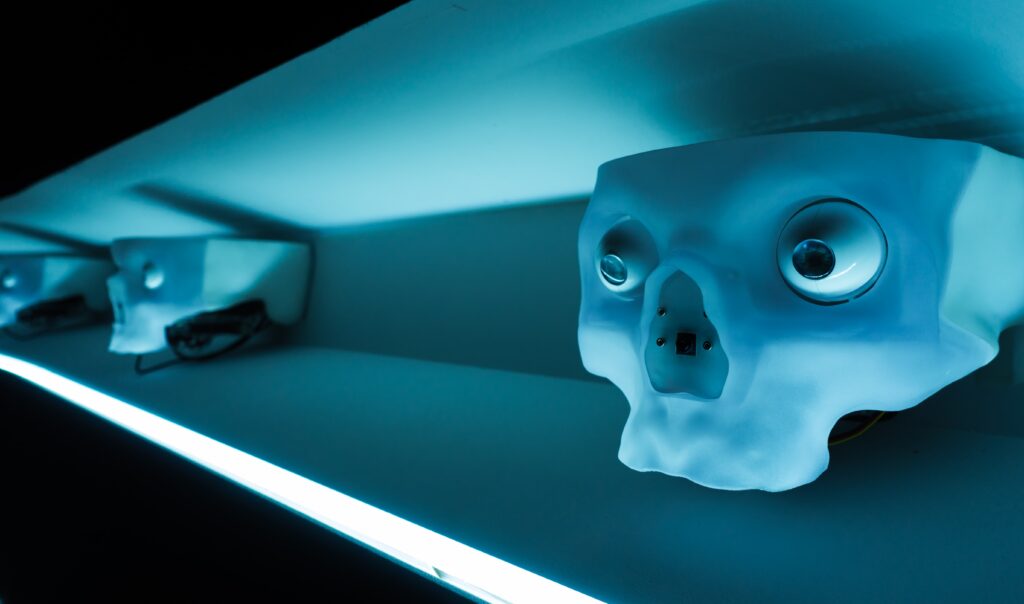

Nightshade fungerer på den måde, at kunstnere kan bruge værktøjet til at tilføje usynlige pixels til deres kunstværk inden de deler det på nettet. De ekstra pixels kan ikke opdages af det menneskelige øje, men de gør en stor forskel, hvis man er en generativ AI-model, der bruger billedet i sine træningsdatasæt. De ekstra data kan fx fortælle modellen, at der er tale om en hund, selvom billedet reelt forestiller en kat.

Zhao og hans hold fodrede forsøgsvis Stable Diffusions nyeste model, som Stable AI selv har trænet 100 % . Ved at give modellen bare 50 ”forgiftede” biller begyndte den at give underlige resultater. Hundene på billederne den nu genererede fik ekstra ben eller tegneserieansigter.

Fordi modellerne er rigtigt gode til at associere ord med hinanden, så skal der ret få ”forgiftede” billeder til for at gøre en forskel. Hvis man ”forgifter” kategorien hund, så spreder modellen selv ”giften” til alle kategorier, som den associerer med hund fx ”hvalp”, ”husky” og ”ulv”.

Fair use

Indtil nu har virksomheder som OpenAI, META og Stable AI henholdt sig til, at deres brug af træningsdata falder ind under princippet ”Fair use” i den amerikanske lovgivning om ophavsret. På dansk taler vi om rimelig brug, der fungerer lidt på samme måde, at man må bruge fx citater fra bøger i et begrænset og rimeligt omfang uden man betaler licens og uden at man krænker kunstnerens ophavsret.

Retssagerne forsøger at udfordre dette standpunkt og har formodentligt en god sag, da træningsdatasæt som fx Books3 ikke indeholder små uddrag, men hele værker ligesom modeller som Midjourney, Dall-E og Stable Diffusion er trænet på hele værker og ikke blot uddrag.

Nogle techvirksomheder tilbyder, at man kan vælge brug af ens data fra, men der på nuværende tidspunkt intet juridisk, der forhindrer virksomhederne i at bruge dataene. Med Nightshade får kunstnerne et stærkt afskrækkende våben overfor techgiganterne, der nu skal til at tænke to gange inden de ukritisk ”scraper” kunstværker på nettet.