TL;DR: Fire hovedpointer

Dette er fjerde del i serien “Hvad er AI?”. Formålet med serien er, at komme med en uddybning af nogle af de centrale begreber indenfor kunstig intelligens og den er altså ikke tænkt til dig, der allerede ved alt om AI. Du kan læse tredje del her.

- Neurale netværk er inspireret af den menneskelige hjerne og fungerer ved at forbinde kunstige neuroner i lag, der lærer at genkende mønstre i data.

- De vigtigste komponenter i et neuralt netværk inkluderer input-, skjulte- og outputlag samt vægte og aktiveringsfunktioner, der styrer neuronernes aktivitet.

- Træning af neurale netværk indebærer justering af vægte via backpropagation for at minimere fejl, men det kan føre til overfitting, hvor modellen præsterer dårligt på nye data.

- Selvom neurale netværk har revolutioneret områder som billed- og talegenkendelse, er de udfordret af forklarbarhed, høje krav til beregningskraft og behovet for store mængder data.

Neurale netværk er en af de mest centrale og avancerede teknologier inden for kunstig intelligens (AI), og de har revolutioneret, hvordan vi løser komplekse problemer som billedgenkendelse, talegenkendelse og naturlig sprogbehandling. For at forstå, hvad neurale netværk er, hvordan de fungerer, og hvorfor de er så effektive, er det nødvendigt at dykke ned i deres opbygning, træningsprocesser, og se på, hvordan vi arbejder med neurale netværk.

Hvad er neurale netværk?

Neurale netværk er en af de vigtigste forudsætninger for AI-teknologiens frembrud i de seneste år. Vi kalder dem neurale netværk fordi de er opbygget på baggrund af den menneskelige hjernes opbygning af neurale netværk. I hjernen består neuroner af små celler, der er forbundet med hinanden gennem synapser. Disse neuroner kommunikerer ved at sende elektriske signaler, og gennem denne kommunikation kan hjernen lære og genkende mønstre. Kunstige neurale netværk efterligner denne struktur ved at bruge “neuroner” i form af små beregningsenheder, der er organiseret i lag og er forbundet med hinanden.

Neurale netværks historie går tilbage til midten af det 20. århundrede, hvor forskere begyndte at udforske muligheden for at efterligne den menneskelige hjernes måde at lære og behandle information på. I 1943 offentliggjorde Warren McCulloch og Walter Pitts en artikel, der beskrev en simpel model af en kunstig neuron, baseret på logiske kredsløb. Denne model lagde grundlaget for neurale netværk ved at vise, hvordan neuroner kunne kombineres til at udføre beregninger.

På den baggrund udviklede Frank Rosenblatt i 1938 perceptronen, den første algoritme til at lære vægte i et neuralt netværk. Perceptronen var en simpel model, der kunne klassificere data i to kategorier, og den anses ofte for at være starten på moderne neurale netværk. I 1969 offentliggjorde Marvin Minsky og Seymour Papert bogen “Perceptrons,” hvor de påpegede begrænsningerne ved enkeltlags perceptroner, især deres manglende evne til at løse ikke-lineære problemer. Denne kritik førte til et fald i interessen for neurale netværk i flere årtier.

Forskere som Geoffrey Hinton og Yann LeCun introducerede i 1980’erne nye metoder som backpropagation, en teknik til at træne dybere netværk ved at justere vægte i flere lag. Dette førte til en fornyet interesse i neurale netværk og deres anvendelser. I løbet af 1990’erne begyndte Neurale netværk at blive anvendt i kommercielle produkter, som for eksempel til håndskriftgenkendelse i banksektoren og optisk tegngenkendelse.Med forbedringer i computerkraft og tilgængeligheden af store datasæt genoplivede dybe neurale netværk, også kendt som dyb læring, interessen for AI i løbet af 2010’erne. Gennembrud i billedgenkendelse, talegenkendelse og naturlig sprogbehandling skete, drevet af dybe læringsmodeller som Convolutional Neural Networks (CNNs) og Recurrent Neural Networks (RNNs).

Neurale netværk er nu kernen i mange AI-systemer, herunder sprogmodeller som GPT og billedgenkendelsesmodeller, der bruges i alt fra medicinsk diagnostik til autonom kørsel. Forskningen fortsætter med at udvikle nye teknikker og arkitekturer, som transformer-modeller, der driver nogle af de mest avancerede AI-systemer i dag.

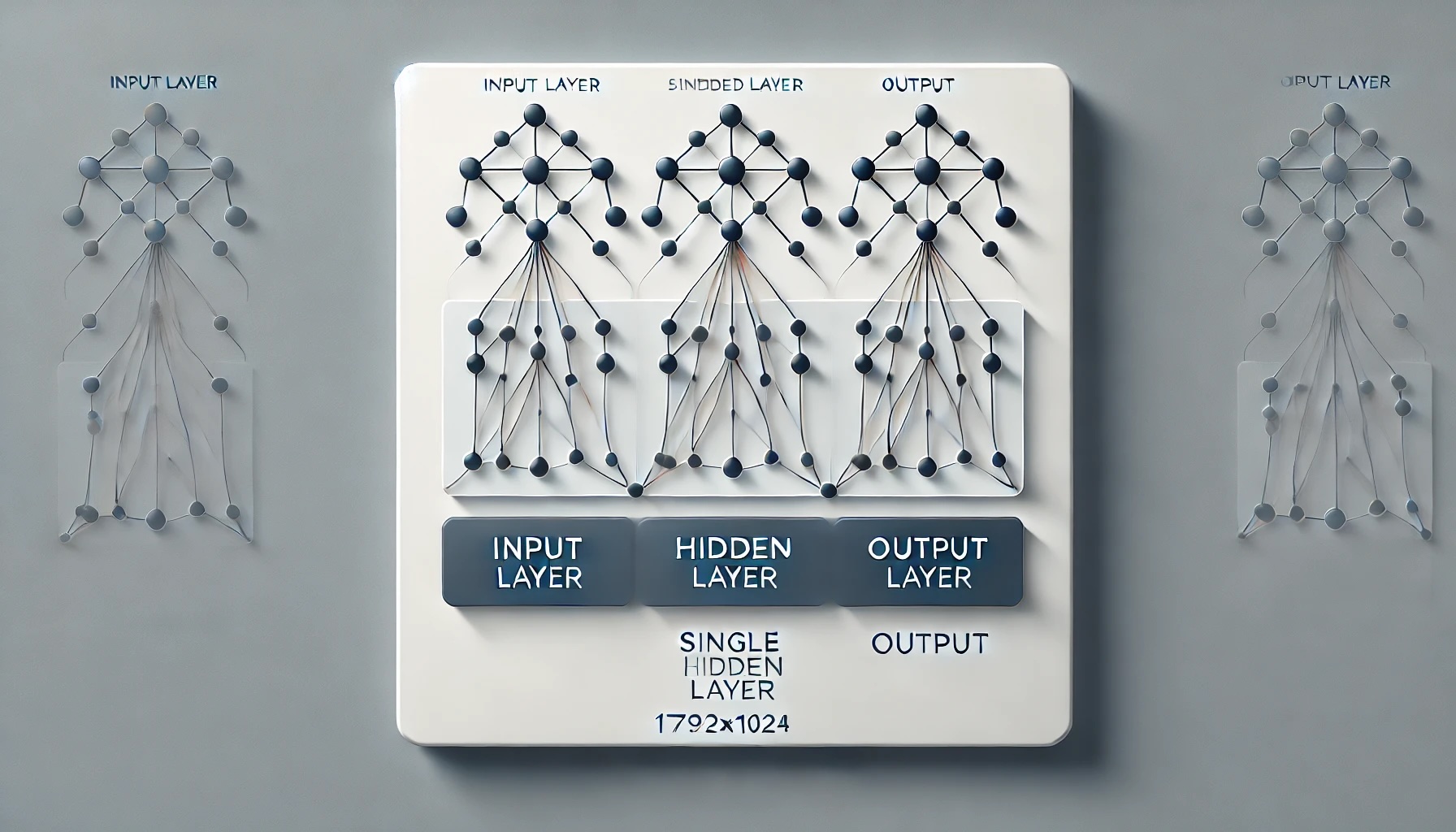

Opbygningen af et neuralt netværk

1. Inputlaget: Dette er det første lag, hvor data indføres i netværket. Hvert neuron i dette lag repræsenterer en funktion af inputdataene, f.eks. en pixelværdi i et billede eller en ordrepræsentation i en tekst.

2. Skjulte lag: Mellem input- og outputlagene findes et eller flere skjulte lag. Disse lag udfører de fleste af de beregninger, der gør det muligt for netværket at lære komplekse mønstre. Antallet af skjulte lag og antallet af neuroner i hvert lag kan variere afhængigt af den specifikke opgave. Når et netværk har mange skjulte lag, kaldes det et dybt neuralt netværk eller dyb læring.

3. Outputlaget: Dette er det sidste lag i netværket, som producerer den endelige forudsigelse eller beslutning. For eksempel kan outputlaget i et netværk, der er trænet til at genkende billeder, angive sandsynligheden for, at et billede indeholder en kat, en hund eller en anden genstand.

Hvordan Fungerer Neurale Netværk?

Neurale netværk fungerer ved at behandle inputdata gennem disse lag af neuroner, hvor hver neuron beregner en vægtet sum af sine input og anvender en aktiveringsfunktion for at bestemme sin output. Dette output sendes derefter videre til neuronerne i det næste lag. Processen gentages, indtil dataene har passeret gennem alle lagene, og netværket leverer sin endelige beslutning eller forudsigelse.

Et af de vigtigste aspekter af neurale netværk er de vægte og bias, som neuroner bruger til at beregne deres output. Vægtene bestemmer, hvor meget hver input påvirker output, mens bias hjælper med at justere outputtet. Disse vægte og bias justeres under træningsprocessen, hvilket gør det muligt for netværket at lære fra data.

En central komponent i et neuralt netværk er aktiveringsfunktionen, som bestemmer, om en neuron skal aktiveres (eller “fyre”). Denne funktion introducerer ikke-linearitet i netværket, hvilket gør det muligt for netværket at lære og repræsentere komplekse mønstre. Uden en aktiveringsfunktion ville netværket kun være i stand til at lære lineære sammenhænge, hvilket ville begrænse dets anvendelighed.

De mest almindelige aktiveringsfunktioner er:

– Sigmoid: Anvendes ofte i de sidste lag af netværk, hvor output skal være en sandsynlighed mellem 0 og 1.

– ReLU (Rectified Linear Unit): En af de mest populære aktiveringsfunktioner i dybe netværk, da den gør det muligt for netværket at konvergere hurtigere og løse gradientproblemer.

– Tanh: Ligner sigmoid-funktionen, men skalerer outputtet til et interval mellem -1 og 1, hvilket gør det mere velegnet til visse opgaver.

Hvordan lærer et neuralt netværk?

Træningsprocessen i neurale netværk er, hvor magien virkelig sker. Når et neuralt netværk trænes, justeres vægtene og bias’ene for hver neuron, så netværket bedre kan forudsige output baseret på input.

Processen begynder med, at netværket får et stort sæt af træningsdata, hvor både input og det korrekte output (etiket) er kendt. Netværket foretager en forudsigelse baseret på de nuværende vægte, og denne forudsigelse sammenlignes med den faktiske etiket. Forskellen mellem den forudsagte og faktiske værdi kaldes fejlen eller tabet.

For at minimere denne fejl bruger neurale netværk en teknik kaldet backpropagation. Backpropagation er en metode, hvor fejlen spredes bagud gennem netværket, og vægtene justeres for at reducere denne fejl i de efterfølgende iterationer. Dette gøres ved hjælp af en algoritme kaldet gradient descent, som hjælper med at finde den kombination af vægte, der minimerer fejlen. Gradient descent fungerer ved at justere vægtene i små trin i retning af den stejleste nedadgående hældning af fejlkurven, indtil netværket når en minimumsfejl.

En af de største udfordringer i træningen af neurale netværk er at undgå overfitting. Overfitting sker, når netværket lærer træningsdataene for godt, inklusive støj og irrelevante detaljer, hvilket resulterer i dårlig ydeevne på nye data. Dette betyder, at modellen ikke generaliserer godt til nye, usete data. For at undgå overfitting kan man bruge teknikker som regularisering, der tilføjer en straf til modellen for at gøre den mindre kompleks eller dropout, der betyder at man tilfældigt deaktiverer neuroner under træningen for at forhindre netværket i at blive for afhængigt af bestemte veje.

Hvordan bruger vi neurale netværk?

Neurale netværk har revolutioneret mange områder. Billedgenkendelse bruges i ansigtsgenkendelse, medicinsk billedanalyse, og selvkørende biler, hvor netværket lærer at genkende objekter og personer på billeder. Stemmeassistenter som Siri, Alexa og Google Assistant bruger neurale netværk til at forstå og reagere på brugerens talte ord. Ved hjælp af naturlig sprogbehandling (Natural Language Processing – NLP): Neurale netværk bruges til at oversætte sprog, analysere tekster, og endda skrive tekster, som det ses med sprogmodeller som GPT-3 og GPT-4. AI i spil, som AlphaGo, bruger neurale netværk til at træffe beslutninger og lære fra spiloplevelser. Selv autonome systemer som droner og robotter bruger neurale netværk til at navigere og interagere med deres omgivelser.

Udfordringer

Selvom neurale netværk er utroligt kraftfulde, har de også visse udfordringer. Dybe neurale netværk fungerer ofte som “sort bokse”, hvilket betyder, at det er svært at forstå, hvordan de træffer deres beslutninger. Dette kan være problematisk i anvendelser, hvor det er vigtigt at kunne forklare og retfærdiggøre en beslutning, som f.eks. i medicinsk diagnostik eller finansielle beslutninger. Krav til beregningskraft kan også være en udfordring i forbindelse med neurale netværk. Især dybe netværk, kræver stor beregningskraft og kan være meget ressourcetunge at træne. Dette gør det vanskeligt for mindre virksomheder og forskere at anvende denne teknologi uden adgang til specialiseret hardware som GPU’er eller TPU’er. Endeligt kræves der store mængder data for at træne et effektivt neuralt netværk kræves. Hvis dataene ikke er af høj kvalitet eller ikke er tilstrækkeligt repræsentative, kan det føre til dårlige resultater.